Perceiver IO: A General Architecture for Structured Inputs & Outputs

내가 이전에 올린 Perceiver에 대한 게시물을 참고하자.

솔직히 말하면 Perceiver에서 크게 달라진 게 있는지는 잘... 모르겠다. 그야 달라지긴 했는데 음..

1. Introduction

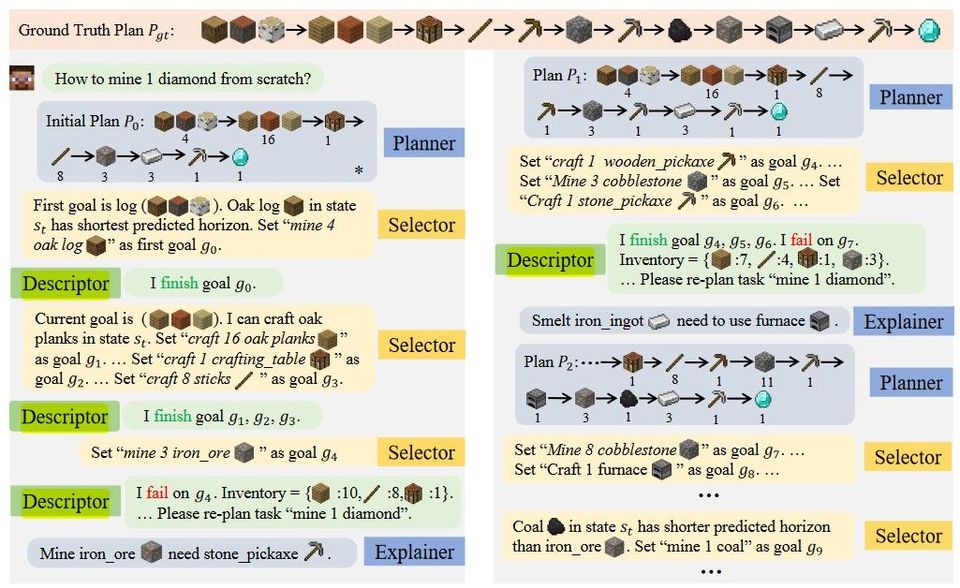

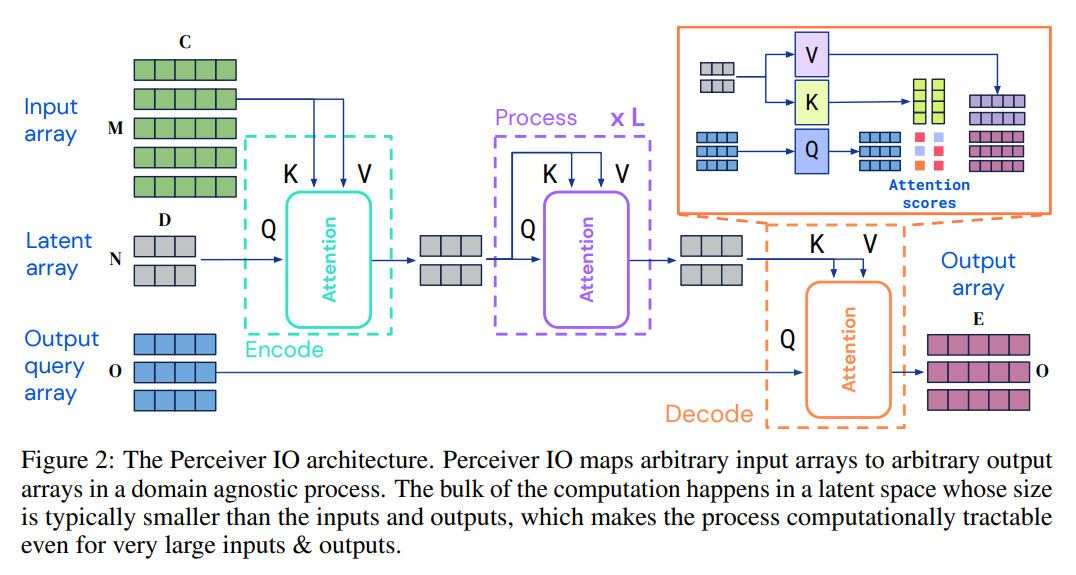

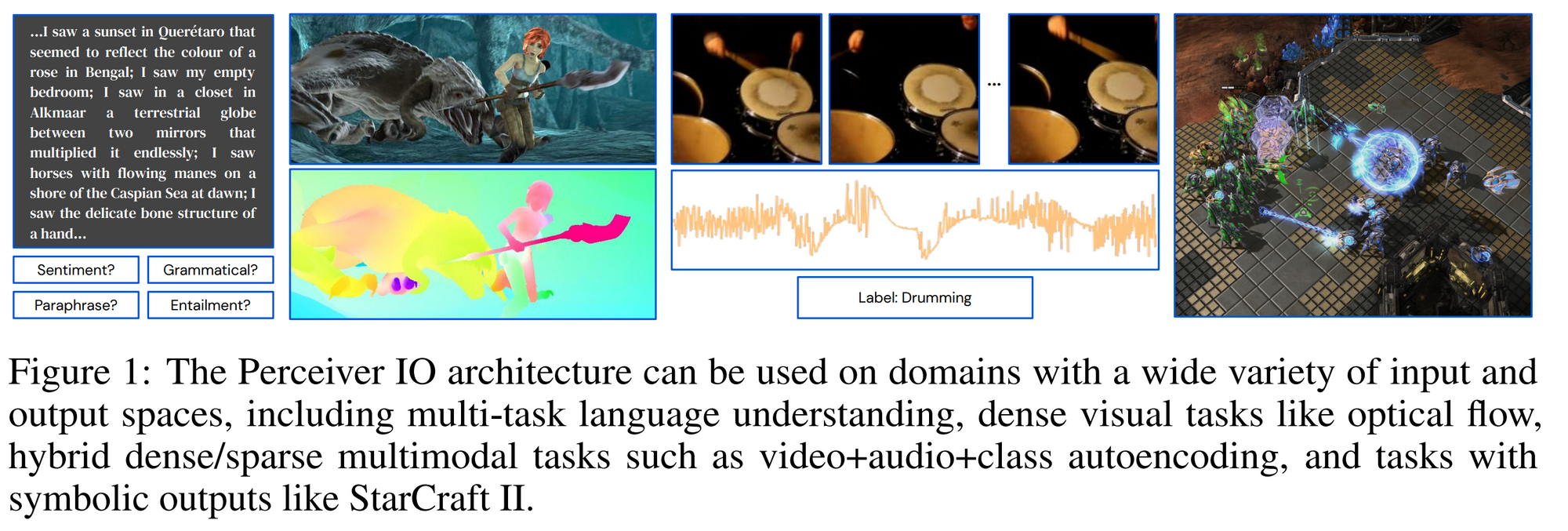

Perceiver IO의 선행모델인 Perceiver에서는 하나의 모델에 다양한 종류의 입력을 입력으로 받을 수 있는, modality-specific details 없이도 학습이 되는 모델을 구현했다. 그러나 Perceiver은 classification과 같은 간단한 작업만 시행할 수 있도록 출력이 나왔고, 이를 개선하기 위해 Perceiver IO를 제시한다. Perceiver IO는 multi-task language understanding, dense visual tasks like optical flow, hybrid dense/sparse multimodal tasks such as video+audio+class autoencoding, and tasks with symbolic outputs like StarCraft II를 할 수 있었다.

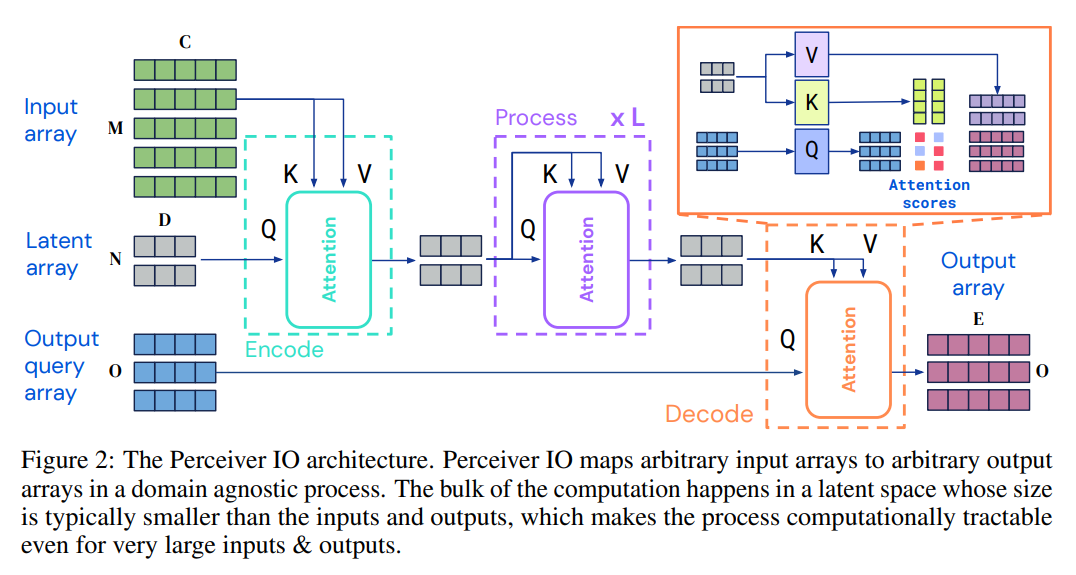

핵심 인사이트는 특정 output과 연관된 output query에 latent vector을 attend시키는 것이다.

-

Our main technical contribution

흥미로운 부분이 중간에 있는데, Perceiver IO가 BERT와 AlphaStar에 쓰이는 Transformer을 대체할 수 있다고 한다.

3. The Perceiver IO architecture

Perceiver에서 나온 Latent array를 K,V로 삼아 output query array에 cross-attention한다.

4. Experiments

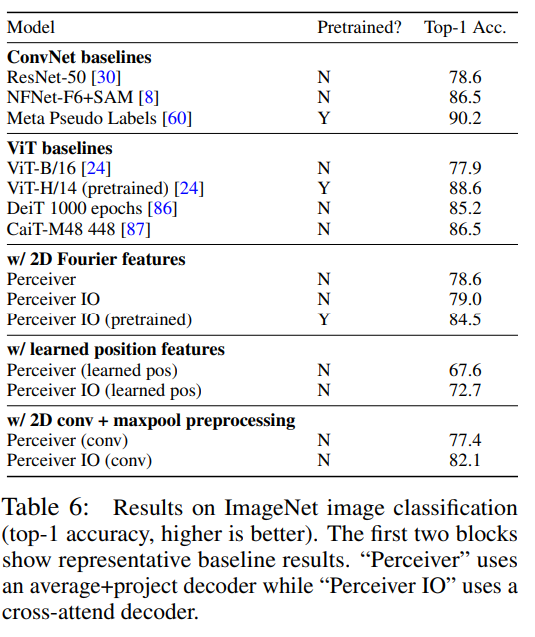

Perceiver의 conclusion에서 large data pre-training해보고 싶다고 했었는데 여기서 그 결과를 제시한다.(JFT) Top-1 Acc 84.5이다.

5. Conclusion

harmful bias에 대한 학습이나 adversarial attack에 대한 위험성 등 ethical perspective에서 이 모델이 취약할지도 모른다고 이야기한다. 그 외에는 general purpose neural network architecture을 제시했다고 하며 끝을 낸다.